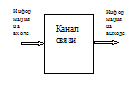

Вспомним о том, что информация передается по каналу связи. Мы ранее ввели информационные характеристики источника информации, а теперь введем информационные характеристики канала. Представим ситуацию так, как показано на рис. 1.

|

На входе канала присутствует входной алфавит, состоящий из множества знаков

, а на выходе -

, а на выходе -  .

.

Источник информации работает на входе канала связи. Согласно общей структуре канала связи, сообщение должно поступать на преобразователь (кодер), который формирует по определенному правилу электрический сигнал. Чаще всего между статистическими параметрами сигнала "u" и сообщения "x" имеется полное соответствие. Это означает, что сообщению  с вероятностью

с вероятностью  соответствует сигнал

соответствует сигнал  с вероятностью

с вероятностью  , причем

, причем  и т. д. В общем случае

и т. д. В общем случае  . По аналогии с сообщением введем энтропию сигнала

. По аналогии с сообщением введем энтропию сигнала  :

:

.Предположим, что помехи в канале отсутствуют. Тогда, каждому переданному сигналу  соответствует строго определенный принятый сигнал

соответствует строго определенный принятый сигнал  . Граф такого канала (рис. 2) состоит из параллельных ребер. По смыслу

. Граф такого канала (рис. 2) состоит из параллельных ребер. По смыслу  характеризует среднее количество информации содержащееся в сигнале. Сигналы имеют разные длительности

характеризует среднее количество информации содержащееся в сигнале. Сигналы имеют разные длительности  . С помощью известного соотношения можно определить среднюю длительность сигнала

. С помощью известного соотношения можно определить среднюю длительность сигнала  :

:

.

.

Количество информации, передаваемое по каналу в единицу времени называется скоростью передачи информации  . Ее можно определить так:

. Ее можно определить так:  .

.

Высокая скорость передачи информации – основное требование, предъявляемое к каналам связи. Однако имеется ряд причин ограничивающих скорость.

Во-первых, энтропия сигнала  , не может принимать максимальное значение, так как вероятности сигналов, как правило, не равны между собой. В этом положении затрагиваются свойства источника информации.

, не может принимать максимальное значение, так как вероятности сигналов, как правило, не равны между собой. В этом положении затрагиваются свойства источника информации.

Во-вторых, сигналы имеют ограниченную длительность. Чем короче сигнал, тем шире должна быть полоса пропускания канала связи. Предельное уменьшение времени  для каждого сигнала потребовало бы применение в канале очень высокочастотных элементов: транзисторов, микросхем, диодов и т.д.. Реализовать такой канал было бы невозможно.

для каждого сигнала потребовало бы применение в канале очень высокочастотных элементов: транзисторов, микросхем, диодов и т.д.. Реализовать такой канал было бы невозможно.

Таким образом, скорость передачи зависит от статистических свойств источника информации и от технических характеристик канала. При всех условиях существует максимально возможная скорость передачи, которая называется пропускной способностью канала C:

.

.

Разберем небольшой пример. Имеем двоичный канал, число сообщений 2. Согласно свойству энтропии, она максимальна при равных вероятностях сообщений. При этом  . Сигналы для передачи – прямоугольные импульсы длительностью

. Сигналы для передачи – прямоугольные импульсы длительностью  (рис.5).

(рис.5).

Для передачи по каналу такого сигнала требуется полоса пропускания  ; чем короче сигнал, тем шире полоса.

; чем короче сигнал, тем шире полоса.

Теоремы Шеннона для канала без помех.

На основании производительности источника  и пропускной способности канала

и пропускной способности канала  основана первая теорема К. Шеннона для канала без помех.

основана первая теорема К. Шеннона для канала без помех.

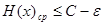

Если производительность источника  меньше пропускной способности канала

меньше пропускной способности канала  ,

,  , где

, где  - сколь угодно малая величина, то по такому каналу можно передать все сообщения источника.

- сколь угодно малая величина, то по такому каналу можно передать все сообщения источника.

|

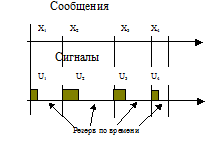

Руководствуясь желанием передать, как можно большее количество информации, мы можем повышать производительность источника до предела, которым является пропускная способность канала. На первом этапе можно просто заставить источник "говорить", создавать информацию, быстрее; канал обладает резервом по времени и успевает ее передать. Это положение иллюстрируется на рис.6.

При дальнейшем уменьшении длительностей сообщений  сигналы начнут "сливаться" и возникает задача сокращения времени каждого из них. А это уже задача кодирования, то есть закона преобразования сообщения в сигнал.

сигналы начнут "сливаться" и возникает задача сокращения времени каждого из них. А это уже задача кодирования, то есть закона преобразования сообщения в сигнал.

1.10 Статистическое или оптимальное кодирование

Существует следующее понятие: " статистическое или оптимальное кодирование". Оно позволяет приблизить скорость передачи к пропускной способности канала и, следовательно, обеспечить наилучшее использование канала без помех. Рассмотрим основные принципы такого кодирования на примере источника независимых сообщений, который необходимо согласовать с двоичным каналом. Вспомним принцип кодирования: это запись сообщений в виде двоичных чисел. Каждые 0 и 1 такого числа – электрические сигналы. Предположим, что длительность такого элементарного сигнала  . Для каждого сообщения

. Для каждого сообщения  представляется сигналом

представляется сигналом  ,которое представляет собой двоичное число имеющее

,которое представляет собой двоичное число имеющее  разрядов. Таким образом, длительность

разрядов. Таким образом, длительность  сигнала будет равна

сигнала будет равна  . Сколько сообщений, столько сигналов и столько же длительностей.

. Сколько сообщений, столько сигналов и столько же длительностей.

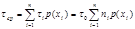

Усреднив длительности, получим среднюю продолжительность сигнала:

.

.

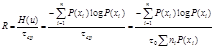

Далее определим скорость передачи  :

:

.

.

Алгоритмы Шеннона-Фано и Хафмена. Принципы их работы простые и похожи. Рассмотрим алгоритм статистического кодирования Хафмена. Обычно для этого заполняется таблица по следующему принципу.

1.В первых двух столбцах располагают сообщения по убыванию их априорных вероятностей.

2.В первом вспомогательном столбце также записываются сообщения по мере убывания вероятностей, но самая последняя записывается в виде суммы двух последних предыдущего столбца.

3.Последующие вспомогательные столбцы записываются по такому же принципу. Последний вспомогательный столбец представлен "1".

4. По данным таблице строится граф с вершиной "1". Ребра графа отражают вероятности, причем ребру с большей вероятностью присваивается значение "1", а с меньшей – "0".

5.Код сообщения получим проходя по ребрам от сообщения к вершине и фиксируя присвоенные значения.

Рассмотрим все это на примере источника информации состоящего из 4-х сообщении. Начнем заполнять таблицу.