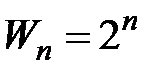

Г. Шульц [355] намагався узагальнити шенонівську ентропію і тим самим створити поняття оціночної ентропії. Він видозмінив ентропію як середнє значення об’єму інформації  окремих станів, щоб її можна було б використовувати не тільки для передачі, але й для оцінки значимості інформації. Г. Шульц встановив оціночну шкалу, по якій найбільш «несприятливому» стану надавалось найнижче значення, а найбільш сприятливому стану – найвище. Для зручності користування значення шкали вибиралися кратними степеню числа 2.

окремих станів, щоб її можна було б використовувати не тільки для передачі, але й для оцінки значимості інформації. Г. Шульц встановив оціночну шкалу, по якій найбільш «несприятливому» стану надавалось найнижче значення, а найбільш сприятливому стану – найвище. Для зручності користування значення шкали вибиралися кратними степеню числа 2.

,

,  ,

,  ,...,

,...,  .

.

З цих значень утворювалися оціночні коефіцієнти

від  до

до  .

.

Вони еквівалентні послідовності частот  .

.

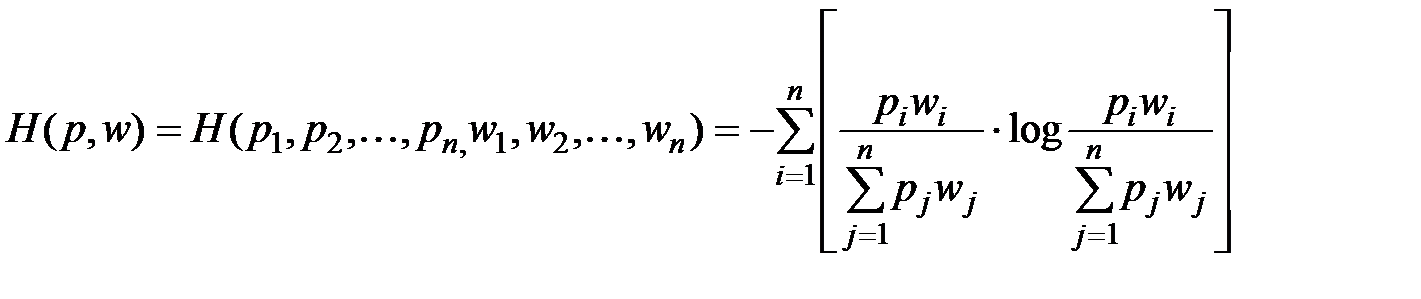

Для забезпечення додаткової умови, яка вимагає, щоб при однаковій семантичній оцінці всіх станів ДІ утворювалась шенонівська оцінка ентропії, використовується формула:

.

.

Легко помітити, що функція  симетрична відносно змінних

симетрична відносно змінних  і

і  . Для

. Для  вона приймає вигляд:

вона приймає вигляд:

,

,

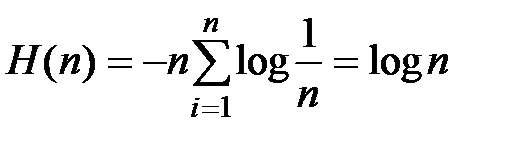

а для  має місце граничний випадок:

має місце граничний випадок:

,

,

де  – кількість можливих станів ДІ, що співпадає з оцінкою Хартлі. Функцію

– кількість можливих станів ДІ, що співпадає з оцінкою Хартлі. Функцію  можна виразити через абсолютні значення

можна виразити через абсолютні значення  і абсолютні частоти

і абсолютні частоти

При цьому вираз:

формально відповідає шеннонівській ентропії:

.

.

Необхідно відмітити, що в виборі оціночних коефіцієнтів  існує певна довільність, яка вносить експертну суб’єктивність в дану оцінку ентропії ДІ.

існує певна довільність, яка вносить експертну суб’єктивність в дану оцінку ентропії ДІ.

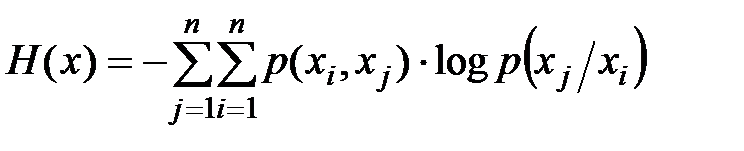

Для дискретного ергодичного ДІ, в якого кореляційні зв’язки існують тільки між двома сусідніми значеннями послідовності  ентропія визначається виразом:

ентропія визначається виразом:

або

,

,

де  – умовна імовірність появи значення

– умовна імовірність появи значення  при умові, що попереднім було значення

при умові, що попереднім було значення  ;

;

– сумісна імовірність появи пари символів

– сумісна імовірність появи пари символів  .

.

В загальному випадку ентропія ергодичних ДІ визначається виразом:

,

,

де  – імовірність послідовності станів

– імовірність послідовності станів  ;

;  – загальна кількість станів джерела;

– загальна кількість станів джерела;  – умовна імовірність появи

– умовна імовірність появи  -го стану при умові, що попередніми були

-го стану при умові, що попередніми були  стани, при чому

стани, при чому  -ий передував

-ий передував  -му, а

-му, а  – найбільш віддалений стан, який має кореляційний зв’язок з

– найбільш віддалений стан, який має кореляційний зв’язок з  -м.

-м.

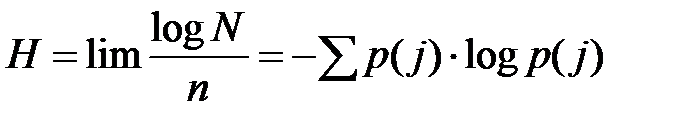

Для джерел з незалежними, але нерівноймовірними станами Б.Олівером [56] отримана оцінка загальної кількості можливих комбінацій станів:

або в логарифмічному вигляді:

,

,

яке на основі наближення Стірлінга

зводиться до виразу:

,

,

що співпадає з шенонівським визначенням ентропії.

Д. Мідлтон [153] також досліджував дискретні ДІ, які формують послідовність символів довільної довжини, розподілених в визначеному порядку в часі. Для реалізації дискретної випадкової послідовності  , кожен із символів

, кожен із символів  якої може приймати одне з

якої може приймати одне з  різних значень (

різних значень (

), отримано вираз для апріорної невизначеності

), отримано вираз для апріорної невизначеності

,

,

де додавання проводиться по всім можливим значенням кожного з символів  послідовності.

послідовності.

Для ДІ з статистично залежними станами Д. Мідлтон визначив вираз середньої умовної ентропії

,

,

де  ,

,  – статистично залежні стани ДІ. З останнього виразу випливає, що для розрахунку ентропії таких ДІ необхідно знати сумісні щільності ймовірностей різного порядку

– статистично залежні стани ДІ. З останнього виразу випливає, що для розрахунку ентропії таких ДІ необхідно знати сумісні щільності ймовірностей різного порядку

...,

...,  .

.

При вивченні статистичних моделей показано, що на практиці ДІ не є настільки статистично складними, щоб їх описувати багатомірними розподілами.

Зокрема, для повного опису ергодичних стаціонарних ДІ достатньо знати двомірні розподіли і відповідно статистично середні. Природно, що ентропія і швидкість створення повідомлень такими джерелами, за рахунок кореляційних зв’язків між різними послідовностями символів і нерівномірності розподілу імовірності символів, виявляються меншими в порівнянні з оцінкою інформаційної міри Хартлі (2.30).

5. Ентропія по Николайчуку. Інші методи визначення ентропії.

Складність обчислення багатовимірних розподілів суттєво обмежує можливості використання шенонівських оцінок ентропії для ДІ з незалежними та статистично залежними станами при інженерному розрахунку їх властивостей, особливо, якщо дослідження інформаційних параметрів конкретних джерел ведуться комп’ютерною системою в реальному масштабі часу. Тому реалізація безпосереднього зв’язку кореляційна функція з розподілами ймовірностей станів і ентропією ДІ є досить перспективною. Такий зв’язок легко встановлюється для неперервних джерел [228].

, (2.32)

, (2.32)

де:  – диференціальна ентропія;

– диференціальна ентропія;

– умовна диференціальна ентропія повідомлення

– умовна диференціальна ентропія повідомлення  ;

;

– щільність сумісного розподілу

– щільність сумісного розподілу  і

і  ;

;

– щільність розподілу

– щільність розподілу  ;

;

– умовна щільність розподілу

– умовна щільність розподілу  відносно

відносно  .

.

Багаторазовими дослідженнями [45, 200] реальних об’єктів управління і джерел інформації показано, що стохастичні параметри технологічних процесів на локальних проміжках часу досить точно описуються моделлю гаусового закону розподілу ймовірностей.

Оцінка ентропії джерел з корельованими станами, які мають гаусовий закон розподілу, визначається за виразом [116, 180]:

.

.

Чисельний розрахунок ентропії дискретного ДІ з нерівноймовірними корельованими станами здійснюється у відповідності з виразом:

, (2.33)

, (2.33)

де перший елемент є константою інформаційної міри, що пов’язана з типом закону розподілу випадкової величини, другий елемент визначає дисперсію випадкових станів ДІ:

,

,

а третій елемент характеризує взаємну ентропію корельованих нерівноймовірних станів ДІ за допомогою квадрату нормованої функції автокореляції:

. (2.34)

. (2.34)

Розрахунок ентропії ДІ на основі оцінки нормованої автокореляційної функції  є незручним при обчисленні в зв’язку з необхідністю центрування послідовності

є незручним при обчисленні в зв’язку з необхідністю центрування послідовності  згідно з (2.34). Для оцінки ентропії ДІ за допомогою структурної функції (2.7) приведемо вираз (3.32) до вигляду:

згідно з (2.34). Для оцінки ентропії ДІ за допомогою структурної функції (2.7) приведемо вираз (3.32) до вигляду:

, (2.35)

, (2.35)

де  .

.

Кореляційна функція для стаціонарних процесів легко виражається через коваріаційну функцію  (2.11), яка значно простіша в обчисленні через відсутність центрування.

(2.11), яка значно простіша в обчисленні через відсутність центрування.

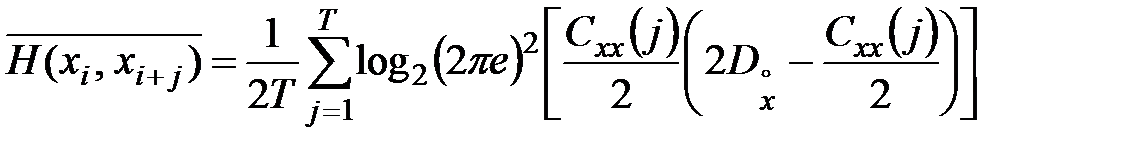

Відповідно, визначення ентропії зручніше здійснювати через автоковаріаційну функцію згідно наступного виразу:

Аналітичний зв’язок між структурною і автокореляційною функціями визначається з (2.11). Підставимо, виражене через  значення

значення  , і отримаємо оцінку:

, і отримаємо оцінку:

. (2.36)

. (2.36)

Якщо оцінити середнє, отримаємо робочу формулу міри ентропії

або

, (2.37)

, (2.37)

де  – інтервал усереднення.

– інтервал усереднення.

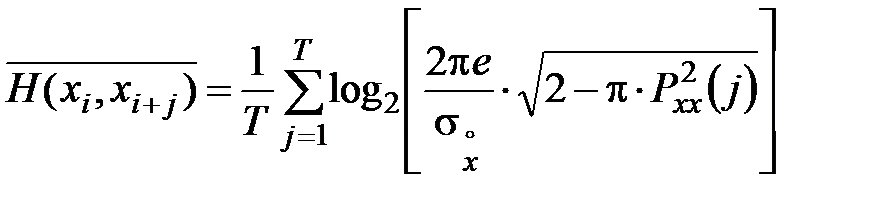

Простіше, порівняно з структурною функцією, обчислюється модульна функція автокореляції  , яка в випадку гаусових процесів має статистичний зв’язок з функцією кореляції (2.12), звідки

, яка в випадку гаусових процесів має статистичний зв’язок з функцією кореляції (2.12), звідки

,

,

де  – нормована модульна функція автокореляції.

– нормована модульна функція автокореляції.

Тоді отримаємо оцінку ентропії у вигляді:

, (2.38)

, (2.38)

яка може бути ефективно використана на практиці в задачах ідентифікації джерел інформації.

Модульна функція має простий аналітичний зв'язок з функцією еквівалентності (2.11), на основі якого, з (2.38) отримаємо оцінку ентропії, виражену через функцію еквівалентності  :

:

. (2.39)

. (2.39)

Аналогічні оцінки можна отримати, якщо використати статистичні зв'язки нормованої кореляційної функції із знаковою  та полярною

та полярною  кореляційними функціями (2.12).

кореляційними функціями (2.12).

Відповідно оцінки ентропії будуть мати вигляд:

; (2.40)

; (2.40)

. (2.41)

. (2.41)

Ентропійна модель, виражена через  , обчислюється з більшою швидкодією, завдяки простішій реалізації функції “менше з двох” ніж операцій множення, віднімання, піднесення до квадрату. Ентропійну модель на основі

, обчислюється з більшою швидкодією, завдяки простішій реалізації функції “менше з двох” ніж операцій множення, віднімання, піднесення до квадрату. Ентропійну модель на основі  доцільно використовувати для обробки даних ДІ, які формують цифрові сигнали із значеннями +1 і –1.

доцільно використовувати для обробки даних ДІ, які формують цифрові сигнали із значеннями +1 і –1.

Аналіз функції  та оцінок

та оцінок  різних дискретних ДІ показує, що при заданому діапазоні квантування станів максимальною ентропією характеризуються дискретні послідовності максимальної довжини.

різних дискретних ДІ показує, що при заданому діапазоні квантування станів максимальною ентропією характеризуються дискретні послідовності максимальної довжини.

Це добре узгоджується з логічними уявленнями про інформаційну ємність дискретних послідовностей і властивостями сигнальних моделей ДІ, що дає можливість достатньо ефективно використовувати при інженерних розрахунках введені міри (2.37) – (2.41).

Реалізуючи обчислення оцінки  на ковзному інтервалі можна алгоритмічно просто здійснити ідентифікацію інформаційних станів технологічних об’єктів контролю та управління в реальному масштабі часу.

на ковзному інтервалі можна алгоритмічно просто здійснити ідентифікацію інформаційних станів технологічних об’єктів контролю та управління в реальному масштабі часу.

Даний клас моделей, по відношенню до кореляційних, здійснюють інтегральну оцінку імовірності переходів між станами і завдяки представленню в логарифмічному просторі забезпечують менші об’єми даних.

Тема 5. Характеристика дискретних джерел інформації. Теорема Шеннона.

План

1. Продуктивність дискретного джерела та швидкість передачі інформації.

2. Ентропія та її властивості.

3. Безумовна ентропія.

4. Умовна ентропія.

5. Ентропія об’єднання двох джерел.