Розглянемо докладніше деякі властивості дискретного джерела повідомлень ті моделі його ансамблю.

Нехай дискретне джерело повідомлень складається з людини-спостерігача та такого фізичного процесу, як колір неба.

Якщо яскравого безхмарного дня в певну мить таким джерелом вибрано повідомлення «синій», то ніяких нових відомостей до наших знань про цей об`єкт воно не дасть, тобто можно сказати, що є повідомлення, але немає інформації, або її кількість дорівнює нулю.

Якщо ж за цих самих обставин джерелом вибрано якесь інше повідомлення про колір неба (наприклад «зелений»), то воно дасть нові відомості про спостережуваний об`єкт, які додадуть до наших знань щось нове. Тоді можна сказати, що є повідомлення і в ньому є якась кількість інформації.

Зараз інформацію на якісному рівні інтуїтивно можна визначити як нове знання про стан спостережуваного об`єкта, а її кількість – як кількість нового знання про нього. Звичайно, якщл нове знання збільшує загальний рівень знання про стан об`єкта, то кількість інформації має накопичуватися додаванням і повинна мати адитивний характер. З іншого боку, спостерігач у певний момент часу нічого не знає про новий стан об`єкта. Він тільки спостерігає його і, лише вибравши нове повідомлення, дозволяє дістати якесь нове знання про об`єкт. Можна сказати, що вибору повідомлення джерелом невизначеність стану об`єкта з боку спостерігача має певний рівень.

Після вибору повідомлення джерелом утворюється деяка кількість інформації про стан спостережуваного об`єкта, яка певною мірою зменшує цю невизначність.

Розгляд дискретного джерела та множини його повідомлень приводить до формування таких природних вимог для визначення кількості інформації:

1.у повідомленні про вірогідний випадок вона має дорівнювати нулю;

2. у двох незалежних повідомленнях вона має дорівнювати сумі кількостей інформації в кожному з них;

3. вона не повинна залежати від якісного змісту повідомлення (ступення його важливості, відомостей тощо).

Кількість інформації в повідомленні тим більша, чим воно менш ймовірне, тобто більш неочікуване.

Середньою потужністю Р с сигналу є потужність, яка забезпечується апаратурою під час його находження до каналу зв’язку.

Частіше замість Р с користуються поняттям динамічного діапазону D с , що визначається логарифмом відношення найбільшої (максимальної) миттєвої потужності сигналу (Pcax=Pc) до найменшої (мінімальної) P c min, дозволене значення якої дорівнює потужності завад

(P c min=Р 3):

D с=log (Р с / Р 3).

Усі ці параметри сигналу є його обсягом:

V c =T c F c D c.

Повідомлення та відповідні сигнали можуть бути неперервними (аналоговими) та дискретними (знаковими).Перші описуються неперервною функцією часу.До них належать такі повідомлення, як музика, телевізійне зображення, радіомовлення.

Дискретне повідомлення – скінченна послідовність окремих символів (знаків, літер) з обмеженою тривалістю. Для перетворення дискретного повідомлення на сигнал потрібна операція кодування.

Неперервні повідомлення можна передавати дискретними способами: неперервні сигнали, якими передаються ці повідомлення, перетворюються на дискретні за допомогою операцій квантування за рівнем та дискретизації в часі. На приймальному боці виконується обернене перетворення: за прийнятими дискретними сигналами відновлюються передані неперервні сигнали.

Дискретні сигнали як засіб передачі повідомлень більш поширені, ніж неперервні,завдяки тому що вони меншою мірою зазнають впливу завад і спотворень в каналах зв’язку,а в разі спотворення їх легше відновити.

Під інформаційною розумітимемо будь-яку систему, яка за допомогою технічних засобів виконує одну або кілька таких функцій,як збирання, передавання, перетворення, накопичення, зберігання та оброблення інформації.

Розподіл систем за функціональною ознакою:

- системи електрозв’язку

- системи передачі даних

- інформаційно-вимірювальні системи

- системи перетворення інформації

- інформаційно-пошукові системи

- системи зберігання інформації

- автоматизовані системи управління

- системи експериментальних досліджень.

Найпоширенішими в повсякденному житті є системи електрозв’язку та передачі даних,які можна об’єднати назвою систем передачі інформації (СПІ).

Лінія зв’язку – це фізичне середовище, в якому поширюються сигнали.

Каналом зв’язку називається сукупність технічних засобів, що забезпечує передачу повідомлень від джерела до одержувача.

Сукупність лінії зв’язку, модулятора та демодулятора (пристроїв перетворення сигналів) утворює неперервний канал передачі інформації,а якщо до цієї сукупності додати ще кодер і декодер, то дістанемо дискретний канал цієї передачі.

Модулятор і демодулятор, конструктивно об’єднані в одному блоці, називаються модемом, а конструктивне об’єднання кодера та декодера – кодеком.

Під способом передачі сигналів розуміють сукупність операцій перетворення повідомлення на сигнал, яку можна подати так:

{ y к.зі(t)}=Λ прд {x i}= Λ м Λ к {x i},

де Λ прд - оператор способу передачі сигналів; Λ м – оператор їх модуляції; Λ к- оператор кодування сигналів.

Сигнали при передачі по лінії зв’язку загасають, піддаючись дії завад і спотворень, що спричинює значні відхилення послідовності сигналів на вході приймача { y п.з і (t)} від переданої в лінію послідовності сигналів { y к.з і (t)}, тобто

{ y п.з і (t)} = Λ л { y к.з і (t)}= Λ л Λ прд {x i}

Де Λ л – оператор лінії зв’язку.

Якщо в лінії є адитивна завада у вигляді випадкового процесу ω(t), то на виході приймача діятиме неперервний випадковий процес

у і (t)-{y п.з(t)} + ω(t).

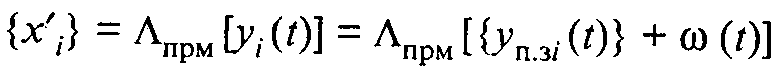

Сукупність операцій перетворення сигналів на повідомлення називається способом їх приймання, який можна відобразити так:

,

,

де Λ прд = Λ дм Λ дк – оператор способу приймання сигналів; Λ дм – оператор їх демодуляції; Λ дк – оператор декодування сигналів.

2. Ентропія та її властивості.

Якщо за час формування джерелом нового повідомлення об`єкт не змінює свій стан (тобто джерелом вибирається попереднє повідомлення з множини А), можна уточнити відомості про попередній стан об`єкта, включивши до цієї множини нові можливі повідомлення та перенормувааши ймовірності з множини Р.

Взагалі з самого початку до складу множини А слід включати такі повідомлення та таку кількість їх, щоб одним повідомленням можна було б визначити стан об`єкта з потрібною точністю.Це означає, що формуючи модель джерела повідомлень (його ансамбль), треба заздалегідь передбачити всі необхідні повідомлення.

Інша справа, що кожне таке повідомлення може бути відображене певною кількістю символів,знаків тощо, переносячи певну кількість інформації. При цьому множина повідомлень А є алфавітом повідомлень, а множина символів, знаків тощо, за допомогою яких спостерігач подає кожне повідомлення у формі, зручній для одержувача,- алфавітом джерела.

Кількість інформації, яка припадає на одне повідомлення характеризує дискретне джерело повідомлень в цілому. Інше джерело з іншим ансамблем повідомлень матиме зовсім іншу питому кількість інформації. Ця загальна характеристика джерела повідомлень називається його ентропією Н (А). Вона має фізичний зміст середньостатистичної міри невизначеності відомостей спостерігача А відносно стану спостережуваного об`єкта.

Точно ентропію можна визначити як математичне сподівання питомої кількості інформації

Необхідні витрати енергії на передачу повідомлення пропорційні його ентропії (середній кількості інформації на одне повідомлення). Виходить, що кількість інформації в послідовностях визначається кількістю повідомлень N у послідовності та ентропією Н(А) джерела, тобто:

і(N)= N Н(А).

Властивості ентропії:

1)Ентропія завжди додатна або дорівнює нулю, тобто невід` ємна.

2)Ентропія є величина адитивна.

Якщо алфавіт А={ а1,а2,…,аk } має k різних повідомлень, то Н(А) ≤log k. Тут рівність стосується тільки рівноймовірних і статично незалежних повідомлень аі є А. Число k називається обсягом алфавіту повідомлень.

Безумовна ентропія

Термін «безумовна ентропія» запозичений з математичної статистики за аналогією з безумовною ймовірністю, що стосується статично незалежних подій, тут – повідомлень.

Безумовна ентропія це кількість інформації, яка припадає на одне повідомлення джерела із статично незалежними повідомленнями.

Якщо є дискретне джерело статично незалежних повідомлень з ансамблем А={ а1,а2,.., аі,…,аk } та р={ p1,…,pі,….pk}, то кількість інформації (середня), що припадає на одне повідомлення аі є А й визначається формулою Шеннона:

є характеристикою цього джерела в цілому.

Наведені властивості ентропії при цьому зберігаються, тобто якщо р=1 або 0,то до ансамблю А не може входити більш як одне повідомлення. Таким чином,

Де невизначність 0 *∞, якщо її розкрити за правилом Лопіталя через граничний перехід, дає

Н0(А)=0.

Безумовна ентропія К рівномірних повідомлень завжди максимальна й визначається виразом

Н(А)=log2K,

Який називається формулою Хартлі.

Таким чином, основними властивостями безумовної ентропії дискретних повідомлень є такі:

Ентропія-величина дійсна, обмежена та невід`ємна;

Ентропія вірогідних повідомлень дорівнює нулю;

Ентропія максимальна, якщо повідомлення рівноймовірні та статично незалежні;

Ентропія джерела з двома альтернативними подіями може змінюватися від 0 до 1;

Ентропія складеного джерела, повідомлення якого складаються з часткових повідомлень кількох статично незалежних джерел, дорівнює сумі ентропії цих джерел.

Умовна ентропія

Теорія математичної статистики вивчає умовну ймовірність через безумовні ймовірності р(а),р(b) та сумісну безумовну ймовірність р(аb) за законом множення ймовірностей:

Для статично незалежних повідомлень а та b маємо

Тобто умовні ймовірності появи повідомлень вироджуються в безумовні.

Розрізняють два ризновиди умовної ентропії:часткову та загальну. Першу знаходять так:

Термін «вибір попереднього» досить умовний, оскільки повідомлення а та b можуть бути рознесені в часі,але знаходитися разом у просторі або бути одночасними чи майже одночасними та рознесеними в просторі. Ніякі обмеження на алфавіти А та В не накладаються. Вони можуть навіть збігатися (А=В). Тому можна аналізувати і враховувати взаємозв`язок між повідомленнями одного й того самого джерела в одному й тому самому алфавіті повідомлень, рознесеними в часі, але не в просторі. Такі послідовності зумовлених повідомлень називаються ланцюгами Маркова.

З іншого боку, алфавіти А та В можуть не збігатися (А≠В), хоча між елементами їх може бути й відповідність.

Алфавіти А та В можуть бути однакового (k= l) і неоднакового (k≠ l)обсягів. Звичайно розглядають ситуації, коли k= l або k‹ l. система спостереження k= l має природне пояснення. Тут спостерігач В повинен реагувати своїм повідомленням bj(j=1… l) на кожний стан джерела А, висловлений повідомленням ai(i=1…k). При цьому діє принцип перетворення a1 →b1, a2 →b2 ,..., aі →bі ,..., aк→bк , коли кожному повідомленню aі джерела А відповідає повідомлення bі джерела В.

Звернемося до фізичного змісту умовної ентропії. Як і при вивченні безумовної ентропії, часткова умовна ентропія є математичним сподіванням значення р(ai / bj) або р(bj / ai). Це поняття відбиває середню за повним алфавітом кількість інформації, що припадає на одне повідомлення цього алфавіту (джерела). Тому Н(А/ bj) є питомою кількістю інформації джерела А за умови, що вже встановлено, факт вибору джерелом В певного повідомлення bj; Н(В/ ai) – питомою кількістю інформації джерела В за умови, що вже відомо стан джерела А. Іншими словами, Н(А/ bj) – це середня кількість інформації, яка містилася в будь-якому повідомленні джерела А, якщо джерело В вибрало повідомлення bj(j=1…k), а Н(В/ ai) – середня кількість інформації, здобутої після вибору джерелом В будь-якого свого повідомлення, коли відомо, що джерело А знаходилося в стані ai(i=1…k). Часткова умовна ентропія визначається як статисне усереднення за методом зваження суми

по індексу і=1...k або j=1…k відповідно.

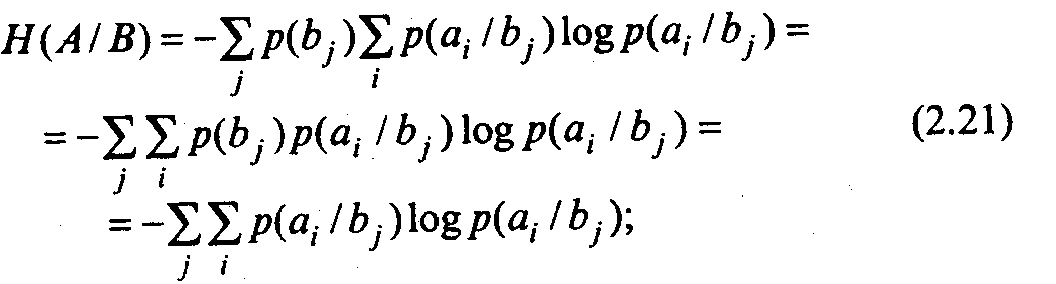

Якщо часткова умовна ентропія джерела А відносно конкретного повідомлення bj дорівнює Н(А/ bj), а розподіл імовірностей Рв джерела В задано ансамблем В із Рв={p(b1 ), …,p(bj), …,p(bk)}, то цілком природно обчислити середнє значення Н(А/ bj) за всіма j як статичне усереднення методом зваженої суми, тобто

де Н(А/В)- загальна умовна ентропія джерела А відносно джерела В. Це питома (середньостатистична) кількість інформації, що припадає на будь-яке повідомлення джерела А, якщо відомо його статистичну взаємозалежність із джерелом В.

Аналогічна загальна умовна ентропія джерела В відносно джерела А визначається виразом

що є питомою кількістю інформації, яка припадає на будь-яке повідомлення джерела В, якщо відомо його статистичну взаємозалежність із джерелом А.

Вирази (2.13),(2.17),(2.18) вирази (2.19) і (2.20) набувають вигляду

5. Ентропія об’єднання двох джерел.

Ентропію Н(А,В) об`єднання двох джерел А та В знаходимо через імовірність сумісної появи пар повідомлень аі,bj для всіх і=1... k та j=1… l, яку позначимо р (аі,bj). Для цього складемо матрицю типу (2.23), що визначає розподіл сумісної безумовної ймовірності двох джерел:

Оскільки р (аі,bj) – це ймовірність сумісної появи двох повідомлень, ентропія Н(А,В) є середньою кількістю інформації, що припадає на два довільних повідомлення джерел А та В й визначається так:

Зрозуміло,що

Оскільки р (аі,bj) = р (bj, аі ).

Розглянемо докладніше вираз (2.36). якщо врахувати (2.13), то можна записати

Згадавши, що логарифм добутку дорівнює сумі логарифмів, матимемо

Тепер потрібно врахувати, що згідно з (2.24)

Тому перша складова в(2.39) відповідно до (2.8) визначає безумовну ентропію джерела А, тобто

А друга складова відповідно до (2.22) є загальною умовою ентропією Н(В/А). Отже,

Властивість симетрії (2.37) дає змогу провести подібні перетворення ще раз і дістати інший вираз ентропії Н(А,В), а саме:

З урахуванням (2.40) і (2.41) загальну умовну ентропію можна визначити порівнянням безумовної ентропії об`єднання джерел та ентропії одного з них – А яи В:

Відзначимо такі основні властивості ентропії об`єднання двох джерел:

1. При статично незалежних повідомленнях джерел А та В ентропія об`єднання їх дорівнює сумі ентропії окремих джерел, тобто

2. При повній статичній залежності джерел А та В ентропія об`єднання їх дорівнює безумовній ентропії одного із джерел, тобто

3. Ентропія об`єднання двох джерел відповідає нерівності

Тема 4. Методи визначення ентропії.

План

1. Ентропія по Хартлі.

2. Ентропія по Шеннону.

3. Ентропія по Колмогорову та ентропія 3s.

4. Ентропія по Шульцу та Мідлтону.

5. Ентропія по Николайчуку. Інші методи визначення ентропії.

Ентропія по Хартлі.

Першу спробу встановити кількісну міру інформації зробив у 1928 р. американський інженер Роберт Хартлі. Ця міра встановлювала здатність різних систем передавати інформацію.

Міру кількості інформації Роберт Хартлі встановив на основі запропонованої ним концепції вибору.

Згідно цієї концепції зв’язок між джерелом інформації (відправником) та її одержувачем (адресатом) здійснюється тільки в тому випадку, коли в системі є сукупність можливих повідомлень, із яких передавач вибирає певне окреме повідомлення. При цьому інформація, що передається окремим повідомленням, залежить від тієї множини інформації, із якої воно вибрано.

Перш за все повинна існувати група фізичних символів, які мають за погодженням відправника і адресату певний зміст. В даній передачі відправник мислительно вибирає той чи інший символ і за допомогою якого-небудь матеріального процесу спрямовує на цей символ одержувача інформації. В результаті послідовних виборів адресат одержить певну послідовність символів.

При кожному виборі вилучають всі інші символи, які могли б бути вибрані. По мірі виконання виборів вилучається все більша і більша кількість послідовностей можливих символів і інформація в адресата стає все більш точною. Наприклад, у реченні „студент ТНЕУ ” перше слово вилучає всі інші групи людей, всі інші об’єкти. Друге слово спрямовує увагу на приналежність студента до певного вузу. Проте, тут не виключаються можливості, що стосуються прізвища студента, його національності, місця проживання і т. п. Подальша інформація про все це може бути передана шляхом наступних виборів.

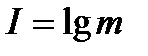

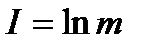

Нехай є m символів системи S, чи m дослідів з різними, рівно можливими послідовними станами системи. Тоді міра різноманітності множини станів системи задається формулою Хартлі

, (1.2)

, (1.2)

де k – коефіцієнт пропорційності (масштабуванння, в залежності від вибраної одиниці вимірювання), а – основна система міри. Ця міра кількості інформації цілком узгоджується з інтуїтивними вимогами до такої міри. Справді, інтуїтивно відчувається, що кількість інформації у повідомленні буде тим більша, чим довше повідомлення і характеристика будь-якого об’єкта буде тим повнішою і кращою, чим більше різноманітних повідомлень є про нього. Наприклад, оцінка студента за 100 бальною системою краще відображає його знання, ніж за п’ятибальною. Зауважимо, що вибір основи логарифму а не є істотним. Оскільки  , то перехід від однієї системи логарифмів до другої зводиться до множення функції f(m) = log m на сталий множник, тобто рівнозначний зміні одиниці вимірювання ступеня невизначеності.

, то перехід від однієї системи логарифмів до другої зводиться до множення функції f(m) = log m на сталий множник, тобто рівнозначний зміні одиниці вимірювання ступеня невизначеності.

Якщо вимірювання ведеться у двійковій системі, то k =1/ ln2,  (біт), якщо в десятковій, то k =1/ ln10,

(біт), якщо в десятковій, то k =1/ ln10,  (біт), якщо в експотенціальній, то k =1,

(біт), якщо в експотенціальній, то k =1,  (ніт).

(ніт).

Оскільки в інформаційних системах використовується двійкова система числення (двійкове кодування), то у формулі (1.2) доцільно покласти а =2.

(1.3)

(1.3)

З точки зору сучасної теорії систем, формулу (1.3) можна тлумачити так:  -це кількість інформації в бітах, яка одержується повідомленням про знаходження системи в одному із m рівно можливих станів.

-це кількість інформації в бітах, яка одержується повідомленням про знаходження системи в одному із m рівно можливих станів.

При цьому біт тут тлумачиться не так, як при технічному підході до оцінювання інформації, де біт – це кількість інформації, яку несе один двійковий розряд і біт є цілим числом.

В концепції вибору за Хартлі, біт – це кількість інформації, яку несе повідомлення про стан системи, яка може знаходитися тільки в одному з двох рівно можливих станів.

Біт – це кількість інформації, яка зменшує невизначеність системи рівно вдвічі.

В концепції Хартлі біт не є обов’язково цілим числом.

Приклад 1. Скільки біт інформації несе повідомлення про появу двохзначного 16-кового числа?

Оскільки всіх різних двохзначних 16-кових чисел є 15*16=240, то система може мати 240 рівноможливих станів. Отже, за формулою (1.3) маємо

(біт)

(біт)

Формула Хартлі (1.3) відволікається від семантичних і якісних, індивідуальних властивостей системи, яка розглядається. Це основний позитив цієї формули. Формула Хартлі зручна для розв’язування деяких практичних задач, проте, в багатьох випадках вона мало придатна тому, що повністю ігнорує відмінності між характером наявних станів. Майже неймовірному стану певної системи тут надається такеж значення, як і цілком правдоподібному. Адже – всі стани рівно можливі.

Сам Хартлі вважав, що відмінності між окремими станами (результатами досліду) визначаються в першу чергу „психологічними факторами” і тому повинні бути враховані лише психологами, але аж ніяк інженерами та математиками.

Помилковість такої точки зору була показана американським математиком та інженером Клодом Шеноном. Про це мова йтиме в наступному параграфі.

Оскільки всіх станів системи є m і всі вони рівно ймовірні, то ймовірність випадкової появи будь-якого з них  . Звідки

. Звідки

Підставивши це значення у формулу (1.3) дістанемо

.

.

Отже, отримали другу формулу Хартлі  (1.4)

(1.4)

Приклад 2. Скільки біт інформації несе повідомлення про те, що ймовірність появи будь-якого із m станів системи дорівнює 0,37. Скориставшись формулою (1.4) дістанемо

(біт).

(біт).

Має місце теорема Хартлі: Якщо у множині Х={х  ,…, х

,…, х  } виділити довільний елемент х

} виділити довільний елемент х  є Х, то для того, щоб знайти його, необхідно одержати не менше log

є Х, то для того, щоб знайти його, необхідно одержати не менше log  m одиниць інформації.[7,с.54-57]

m одиниць інформації.[7,с.54-57]

Приклад 3. Є 27 монет, із яких одна фальшива (легша). Скільки зважувань треба виконати, щоб виявити фальшиву монету?

Кожне зважування групи монет на терезах дає log  3 біт інформації (подумайте чому?). Всіх зважувань треба виконати Х. Отже, Х log

3 біт інформації (подумайте чому?). Всіх зважувань треба виконати Х. Отже, Х log  3= log

3= log  27. Звідки Х=3.

27. Звідки Х=3.

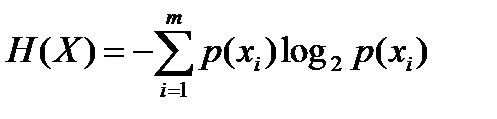

2. Ентропія по Шеннону.

Ідеї Хартлі розвинув і узагальнив американський вчений Клод Шенон в науковій праці „Математична теорія зв’язку”. Клод Шенон підійшов з ймовірних позицій вимірювання інформації, враховуючи ту обставину, що в переважній більшості випадків доводиться мати справу з такими системами, стани яких не є рівно ймовірними (рівно можливими).

Наприклад, в ролі такої системи можна взяти систему побудови тексту (послідовності букв) над абстрактним алфавітом, що складається із m різних букв. Окремі букви цього алфавіту появляються в тексті з різною ймовірністю і в залежності від попередніх букв цього тексту.

Нехай запущено на ПК програму–генератор, яка на екрані монітора може демонструвати появу будь-якої букви із заданого алфавіту X (X1, X2, … Xm). Кожна буква появляється на екрані згідно із ймовірністю її появи p (x i). Нехай на екрані послідовно появилась послідовність із n букв (n досить велике число, значно більше за m). Якщо нас зацікавить буква x i, то вона на екрані з’явиться приблизно (n ∙ p (x i) разів. Кожна поява на екрані букви x i дає за формулою (1.4) кількість інформації, що дорівнює  біт. Усього (за всі появи букви x i) буде одержано (– n ∙ p (x i)∙log2(p (x i)) бітів інформації.

біт. Усього (за всі появи букви x i) буде одержано (– n ∙ p (x i)∙log2(p (x i)) бітів інформації.

Загальна кількість інформації, яку потрібно просумувати після демонстрації цієї послідовності із n букв, дорівнює:

(біт) (1.5)

(біт) (1.5)

Співвідношення (1.5) було одержано в 1948 р. К.Шеноном для визначення середньої кількості інформації у повідомленні, що складається із незалежних і нерівноймовірних елементів. Якщо всі стани системи є рівноймовірними, тобто

p (x 1)= p (x 2)=…= p (xm)=  ,

,

то I =

Отже, з (1.5), як окремий випадок, при n =1, одержується формула Хартлі (1.3). Саме формулу (1.5) вивів, виходячи з імовірнісних позицій, Клод Шенон.

Основними поняттями започаткованої Шеноном статистичної теорії інформації, яка викладена в роботі „Математична теорія зв’язку” є введене ним поняття інформаційної ентропії.

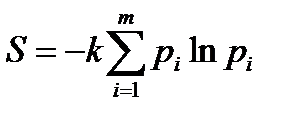

Ентропія в теорії інформації є мірою невизначеності, яка існує при одержанні повідомлень. Свою назву міра невизначеності одержала завдяки зовнішній схожості з термодинамічною ентропією. Пригадаймо з курсу фізики формулу  , де k – коефіцієнт Больцмана (k=1,38∙10-16 ерг/град), яка відома в термодинаміці як ентропія чи міра хаосу, безладдя в системі. Завдяки зовнішній схожості міри невизначеності і термодинамічної ентропії Джон фон Нейман (один з основоположників обчислювальної техніки) запропонував Шенону використати термін „ентропія” і в обчислювальній техніці. При цьому він жартома зауважив: „що таке ентропія не знає ніхто”.

, де k – коефіцієнт Больцмана (k=1,38∙10-16 ерг/град), яка відома в термодинаміці як ентропія чи міра хаосу, безладдя в системі. Завдяки зовнішній схожості міри невизначеності і термодинамічної ентропії Джон фон Нейман (один з основоположників обчислювальної техніки) запропонував Шенону використати термін „ентропія” і в обчислювальній техніці. При цьому він жартома зауважив: „що таке ентропія не знає ніхто”.

Згідно з основним положенням статистичної теорії інформації, будь-яке повідомлення, що буде передаватися, є результатом випадкового вибору із множини можливих повідомлень даного типу. Оскільки вибір є випадковим, то існує невизначеність, яка знімається тільки після одержання повідомлення. Міра невизначеності для одержувача інформації залежить від того, наскільки великим є вибір із множини можливих повідомлень.

Ентропія, як оцінка невизначеності, відображає здатність матеріального джерела проявляти все нові і нові стани і таким чином генерувати інформацію. Інформація за Шеноном — це повідомлення, яке зменшує невизначеність системи (події), що існувала до одержання повідомлення.

Зміст ентропії полягає в тому, що її збільшення означає зменшення впорядкованості системи. Безладною система залишається тільки тоді, коли про неї дуже мало знаємо. Ентропія такої системи для нас велика. З набуттям нових знань про систему, з надходженням певної інформації, ентропія системи зменшується. Отже, надходження інформації сприяє зменшенню ентропії. Це зменшення пропорційне інформації, яка надходить. Таким чином, за міру інформації можна взяти певну кількість ентропії, яка відповідає цій інформації.

Нехай є система X з дискретною множиною можливих станів x 1, x 2, …, x m, які утворюють повну групу подій з відповідними ймовірностями p (x 1), p (x 2), …, p (x m). Тоді функцію

(1.6)

де логарифми беруться при довільній, але у всіх випадках одній і тій же основі a, Шенон назвав ентропією системи X.

При p (x i)=0 завжди приймають, що і p (x i)∙log p (x i)=0. Цій функції притаманні властивості, які є необхідними для міри невизначеності систем.

1. Ентропія є дійсною і додатною функцією аргументів p (x i), що змінюються в інтервалі від 0 до 1.

2. Ентропія H (X)=0 тоді, коли одне із значень p (x 1), p (x 2), …, p (x m) дорівнює одиниці, а всі інші – нулю. Але це саме той випадок, коли результат випробовування може бути передбачений заздалегідь з певною достовірністю. Але в цьому випадку невизначеність системи відсутня, вона рівна нулю.

3. Функція H (X) набирає максимального значення loga m, коли стани системи рівноймовірні, тобто коли p (x 1)= p (x 2)=…= p (x m)=  .

.

4. Невизначеність складеної системи дорівнює сумі невизначеності її незалежних складових (властивість адитивності для незалежних систем X і Y). H (X,Y)= H (X)+ H (Y).

5. Ентропія H (X) неперервно залежить від ймовірностей станів системи X, тобто при досить малій зміні ймовірностей x i (i =1, 2,…, m) ентропія змінюється дуже мало.

6. Ентропія системи, яка має тільки два нерівноймовірні стани (m =2), може змінюватися від нуля до одиниці.

Шенон довів єдність існування ентропії (1.6) для системи X.

Як зазначено в самому означенні ентропії, основа логарифма в (1.6) відповідає одиниці вимірювання ентропії. Якщо a =2, то ентропія вимірюється в бітах, а якщо a =10 – в десяткових одиницях або дітах, якщо a =e – в натуральних одиниця або нітах.

Найбільш поширеними є двійкові одиниці вимірювання. Тому в наступному будемо розглядати ентропію (1.4) при основі логарифма a =2.

(1.7)

Із порівняння формул (1.5) та (1.7) випливає, що

I = n ∙ H (X) (1.8),

де I – кількість інформації у повідомленні із n елементів, а H(X) – ентропія на один елемент повідомлення.

Залежність (1.8) обумовлюється самими процесом одержання інформації. Справді, до одержання повідомлення відомими є лише загальна кількість можливих повідомлень та їх ймовірності. Отже, є невизначеність відносно того, яке повідомлення буде послано і ця невизначеність вимірюється ентропією H(X).

Як тільки повідомлення одержано, невизначеність повністю знімається. Отже, після прийому повідомлення відбувається зменшення ентропії від H(X) до нуля, а з другого боку – одержання інформації від нуля до I (при n=1). Тому кількість інформації тут чисельно дорівнює апріорній ентропії системи.

Зазначимо, що Клод Шенон фактично не робив різниці між ентропією і кількістю інформації, а Норберт Вінер підкреслював, що кількість інформації – це деяка від’ємна ентропія.

Основними позитивними сторонами формул Шенона (1.5), (1.6) є їх абстрагування від семантичних і якісних, індивідуальних властивостей системи. На відміну від формул Хартлі формули Шенона враховують різноймовірність станів системи, структуру повідомлень (мають статистичний характер). Формули зручні для практичних обчислень.

Справжня цінність Шенонівського поняття ентропії полягає в тому, що виражена нею „ступінь невизначеності події„ (стану системи) виявляється в багатьох випадках саме тією характеристикою, яка відіграє важливу роль в різноманітних процесах, які зустрічаються в природі і техніці, або так чи інакше пов’язаних з передачею та зберіганням інформації.

За Шеноном кількість інформації у повідомленні визначається за формулою

I=H0-H1, (1.9)

де H0 – ентропія системи до одержання повідомлення, а H1 – ентропія системи після одержання повідомлення. Для випадку, коли стани системи рівнонеймовірні і незалежні, H0 і H1 вимірюються за формулою (1.3).

Приклад 1. На факультеті 512 студентів, серед них 64 – відмінників. Яку кількість інформації несе повідомлення „Перше місце на олімпіаді зайняв студент-відмінник”?

За формулою (1.2) одержимо

H0=log2512=log229=9 (біт)

H1=log264=log226=6 (біт)

За формулою (1.9) одержимо

І=9-6=3 (біти)

Приклад 2. Клавіатура ПК має 103 клавіші. Яку кількість інформації несе повідомлення „Набрано текст із 12 великих латинських букв”?

Згідно з теоремою про кількість слів довжини n над алфавітом потужності n, маємо: [11, с.26]

H0=log210312=12∙log2103≈80,2 (біт)

H1=log22612=12∙log226≈56,4 (біт)

За формулою (1.12) одержуємо

І=80,2-56,4=23,8 (біт)

Приклад 3. В двох урнах є по 40 кульок. В першій урні – 10 білих, 10 червоних і 20 жовтих. В другій урні – 15 білих, 20 червоних і 5 жовтих. Із кожної урни виймають по одній кульці. В якому із цих випробовувань більше невизначеності?

,

,

p (x 2)=0,25,

Обрахуємо H(X) та H(Y) за формулою (1.7).

H(X) = – (0,25log20,25+0,25log20,25+0,5log20,5)=

= (0,34666+0,34666+0,34657)/0,6934=1,5

H(Y) = – (0,375log20,375+0,5log20,5+0,125log20,125)=

= (0,98002+0,34657+0,34666)/0,694=1,4056

Отже, більше невизначеності у першому випробуванні.

Приклад 4. Дано частотний словник української мови

Таблиця 2

| Буква | Частота | Буква | Частота | Буква | Частота |

| а, і | 0,062 | к | 0,022 | ф | 0,0018 |

| б, ь | 0,014 | л, м | 0,026 | х | 0,009 |

| в | 0,035 | т, н | 0,053 | ц, щ | 0,008 |

| г | 0,065 | о | 0,090 | ч | 0,013 |

| д | 0,025 | п | 0,023 | я | 0,018 |

| е, є | 0,072 | р | 0,040 | й | 0,012 |

| ж, ю, ч | 0,010 | с | 0,045 | ї | 0,062 |

| з, и | 0,016 | у | 0,021 | ґ | 0,040 |

Яку кількість інформації містить слово „ХЛІБ”?

І = – 4(0,009log20,009+0,026log20,026+0,062log20,062+0,014log20,014)=

= –4 (-0,5342) = 2,132.