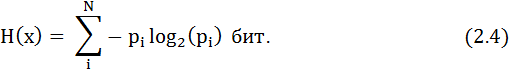

Дербес оқиғаның ақпараты анықталғаннан кейін оқиғалардың дереккөзін қарастырайық. Оны суреттеу үшін оның құрамындағы оқиғалардың ақпараттарын қолданамыз. Термодинамикадағы секілді энтропия түсінігін енгіземіз. Термодинамикада энтропия жүйенің реттелмегендік тәсілі болып табылады. Ақпараттар теориясында энтропияға дереккөздің реттелмегендік әдісі деген анықтама береді. Дербес оқиғалардың ақпараттарын пайдаланып, дереккөз энтропиясын келесі келесі түрде бейнелейміз:

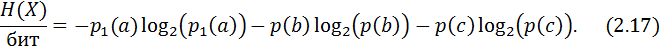

X = {х1, х2,..., хN} алфавитті және сәйкес р1, р2,..., рN ықтималдықты қарапайым жадсыз дереккөздің энтропиясы тең болады

Өзімізге дереккөздің кейбір оқиғалары мағлұм болатын ойынды елестетейік. Егер дереккөз әлдеқандай оқиғаға көз қырын салса, сіз оған батыл түрде тігіңіз және көп жағдайда сіз ұтатын боласыз. Егер барлық оқиғалар тең ықтималды болса, онда кез-келген оқиғаға тігіңіз: егер оқиғаның белгісіздігі максималды болса, ұтуға мүмкіндіктер минималды.

Мысал: Энтропияны бағалау.

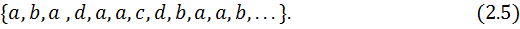

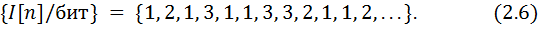

Бұл байланысты 2.1 кестедегі қарапайым жадыз дискретті дереккөз мысалында қарастырайық. Дереккөз ақпараты өзімен кездейсоқ a, b, c, d оқиғаларымен болған тәжірибенің нәтижесін ұсынады. Бұл тәжірибені қайталау нәтижесінде біз келесі реттілікті ұшыратамыз

2.1 Кесте. рi ықтималдықты X = {a, b, c, d} алфавит символды және I(pi) ақпаратты жадсыз дискретті дереккөз.

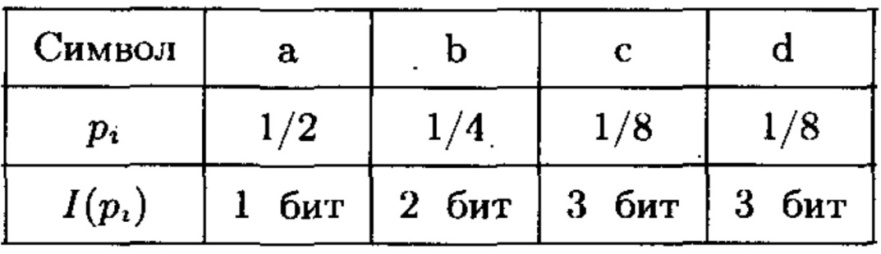

Әр оқиғаның орнына оның ақпаратын қояр болсақ, әдеттегі стохастикалық процес формуласын аламыз

Мұндай уақыт процесінің эргодтылығын(тәртіп тұрақтылығы) елестетейік. Мұндай эргодтылықты біз, мәселен, тиын немесе ойын кубын лақтырғанда ықтималдаймыз. N сынақ санының өсуімен дереккөз ақпаратының орташа мәні

Математикалық күтіміне ұмтылады

Осылайша, (2.7) қатардың математикалық күтіммен сәйкестігін есепке алсақ, дереккөз ақпараты үшін практикалық тәсіл аламыз. Қарастырылған мысалда Е(I) математикалық күтімі 1,75 битке тең. Бастапқы 12 сынақтан біз сонымен қатар (I)n үшін 1,75 бит бағасын аламыз.

Ұқсас талқылаулар жүргізіп, Шеннон [1] энтропия анықтамасына келесі үш аксиоманы енгізеді.

Энтропияның аксиомалық анықтамасы:

1. Н(Х) = f(p1, p2,..., pN) энтропиясы р1, р2,..., рN ықтималдықтарының үздіксіз фунциясы болып табылады.

2. Біркелкі рі =  ықтималдықты оқиғалар дереккөздері үшін энтропия N оқиға санының жоғарылауымен өседі.

ықтималдықты оқиғалар дереккөздері үшін энтропия N оқиға санының жоғарылауымен өседі.

3. Оқиға таңдау рәсімінің бірнеше бөлікке бөлінуі энтропияны өзгертпейді (таңдау рәсімін реттілік екілік шешімге теңеуге болады).

Мысал: Таңдау рәсімінің ыдырауы.

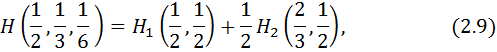

Бұл мысал 3 аксиоманы айқындайды. Үш а, b және с оқиғаларын сәйкес 1/2, 1/3 және 1/6 ықтималдықтарымен қарастырайық. Бұл үшеуінің біреуін таңдау үшін, біз екі тәуелсіз сауал қоя аламыз (2.3 сурет).

2.3 Сурет. Символ таңдау рәсімінің ыдырауы

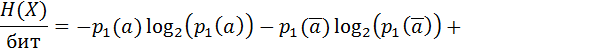

Бұл сұрақтарға екі ғана жауап берілуі мүмкін: “ия” немесе “жоқ”. Аксиома (3)-ке сәйкес, энтропияға келесі талап қойылады:

бұған қоса екінші сұрақ 1/2 ықтималдығымен қойылады. Біз энтропия (2.8) анықтамасы аксиома (Н3) талаптарына сай екенін жалпы көріністе (2.4 сурет) көрсетеміз.

2.4 Сурет. Шешім қабылдау рәсімінің ыдырауы

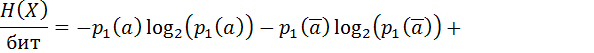

Ыдыраған энтропия үшін алатынымыз

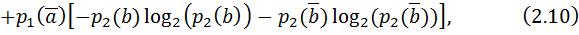

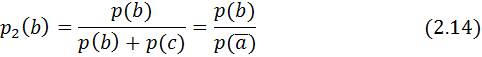

мұндағы ықтималдықтар келесі түрде анықталады

Ескерту. Ақырғы теңдік кездейсоқ оқиғалармен тәжірибе қою арқылы дәлелденеді. Оқиға а 300 мәрте, b оқиғасы – 200, ал с оқиғасы – 100 рет орындалған болсын. Бұл мәселеде әр оқиғаның жиілігі оның ықтималдығына тең. Егер біз а оқиғасын шығарып тастасақ, b және с оқиғаларынан 300 талғау қалады, бұл оқиғалардың талғау жиілігі екі еселенеді, бірақ олардың байланыстары өзгермейді.

Екінші қадамдағы ықтималдықтарды (2.11) – (2.13) сәйкес келесі түрде суреттеуге болады

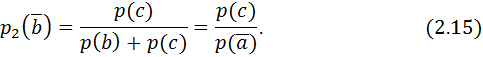

Энтропия формуласына алынған өрнектерді қойғанда, шығатыны

жеңілдетуден кейін оқиға таңдау рәсімі ыдырамаған энтропияға сәйкес келеді

Қарастырылған мысалда логарифмдік функцияның туындыны қосындыға аударатын қасиеті қолданылған болатын. (2.4) анықтама 3 аксиома күшін жоймайтын жалғыз анықтама. Тағы байқайтынымыз, қарастырылған оқиға таңдау рәсімінің ыдырауы реттелген “ия” және “жоқ” бинарлы шешіміне әкеледі. Максималды белгісіздікке дереккөздің максималды энтропиясы сәйкес. Келесі теореманы құрастырайық:

2.2.1 Теоремасы. Қарапайым жадсыз дискретті дереккөздің энтропиясы, ондағы барлық оқиғалар біркелкі ықтималдыққа ие болса, максималды. Бұл жағдайда энтропия оқиғалар санының логарифміне тең

Ескерту. Теореманың келесі дәлелі ақпараттар теориясында әдеттегідей жағдай болып табылады. Мұндай дәлелдерде алдын мағлұм болған, бірақ практикалық қолданыста болмаған бағалар және шектік өткелдер қолданылады.

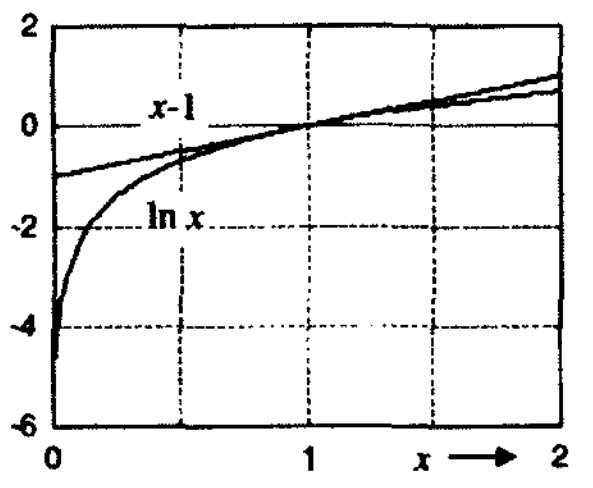

2.5 Сурет. Логарифмдік функцияның жоғарғы бағасы.

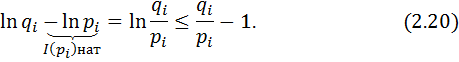

Дәлел. Дәлел үшін әрқайсысы сәйкес рі және qi ықтималдықты N оқиғалы екі P және Q жадсыз дискретті дереккөздерін қарастырайық. Әрмен қарай, мәшһүр логарифмдік функцияның жоғарғы бағалау әдісін қолданамыз (2.5 сурет)

Мұны пайдаланып, алатынымыз

Теңсіздіктің екі бөлігін де рі -ге көбейтіп және барлық 1 ≤ i ≤ N оқиғаларды қосқанда, шығатыны

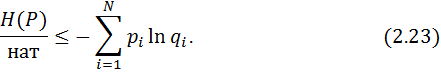

Жеңілдеткеннен кейін шығатыны

демек

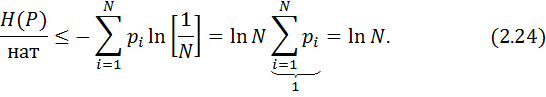

Q дереккөзі тек тең ықтималды оқиғалардан тұрады деп есептейік. Онда

Дәлелдеу үрдісінде Р дереккөзіне ешқандай шектеу қойылмағандықтан, онда бұл теңсіздік кез-келген N оқиғалы жадсыз дискретті дереккөз үшін орынды

Максимумға барлық оқиғалар біркелкі ықтималдықты болса ғана жетеміз.

Барлығы біркелкі ықтималдықты емес, N оқиғалы кез-келген дереккөз log2N-нен төмен энтропияға ие. Ешқашан толмайтын мағлұмат сақтау резервуары ретінде H0 = log2N сыйымдылықты дереккөзді қарастырамыз.

Н0 максималды сыйымдылығы менен N оқиғалы Х дереккөзінің энтропиясының арасындағы айырмашылық, дереккөздің ысырабы деп аталады.

Теріс шығын мына түрде анықталады

Мысал: 6 оқиғадан тұратын жадсыз дискретті дереккөздің энтропиясы

2.2 Кесте. X = {a, b, c, d, e, f} алфавитті хі символы менен және рі ықтималдықты һәм I(pi) ақпаратты жадсыз дискретті дереккөз.

Жоғарыда келтірілген анықтамаларды нақтылау үшін сандық мысалды қарастырайық. 2.2 кестеде сәйкес алфавитімен және оқиға ықтималдықтарымен Х жадсыз дискретті дереккөзі берілген. (2.3)-ке сүйене отырып, әр оқиғаның ақпаратын есептеп кестені мәндермен толтырамыз.

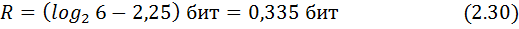

Дереккөз энтропиясы

Оқиғалар үшін Н0 мәні

сонда шығын

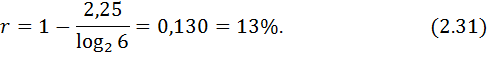

және, сәкес, теріс шығын

Ерекше назар аударарлық жәйт екілік жадсыз дискретті дереккөздер, себебі көп жағдайларда олардың көмегімен ақпарат тасымалдау процессін сипаттай аламыз.

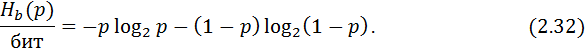

Х ={0,1} алфавитті және “0” және “1” символдары үшін сәйкес р0 = p және p1 = 1 – p0 ықтималдықты екілік жадсыз дискретті дереккөз берілген болсын. Символ талғау тәуелсіз мәртебеде өтеді. Әрі Шеннон функциясы деп аталатын оның энтропиясы тек қана р ықтималдығына тәуелді.

Екілік дереккөз энтропиясы (Шеннон функциясы)

2.6 суретте Шеннон функциясының тәртібі көрсетілген. Екілік дереккөз энтропиясы барлық жерде оң мәнді және теріс р = 1/2 симметриялы һәм біркелкі ықтималдықты “0” және “1” символдарының тұсында максимумға ие. 1 битке тең максималды энтропия екілік шешімге сәйкес, яғни символдың мәні хақындағы сауалға бір ғана жауап бар: “ия” немесе “жоқ”.

2.6 Сурет. Екілік дереккөз энтропиясы.

БӨЛІМ

ЖАДСЫЗ ДИСКРЕТТІ