Парная регрессия представляет собой уравнение, описывающее связь между двумя переменными: зависимой переменной  и независимой переменной

и независимой переменной  . Иногда переменную

. Иногда переменную  называют результатом, а переменную

называют результатом, а переменную  – фактором:

– фактором:

, при этом функция может быть как линейной, так и нелинейной. В данной главе более детально рассмотрим линейную парную регрессию. Предположим, что у нас есть набор значений двух переменных

, при этом функция может быть как линейной, так и нелинейной. В данной главе более детально рассмотрим линейную парную регрессию. Предположим, что у нас есть набор значений двух переменных  Соответствующие пары

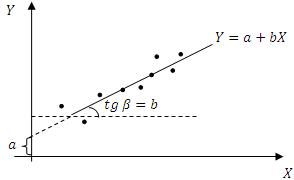

Соответствующие пары  можно изобразить на одной плоскости:

можно изобразить на одной плоскости:

Параметр  соответствует отрезку прямой, отсекаемому линией регрессии при пересечении с осью ординат, параметр b определяет наклон линии регрессии к оси абсцисс. При этом параметр a традиционно принято называть свободным членом регрессии, а параметр

соответствует отрезку прямой, отсекаемому линией регрессии при пересечении с осью ординат, параметр b определяет наклон линии регрессии к оси абсцисс. При этом параметр a традиционно принято называть свободным членом регрессии, а параметр  – коэффициентом регрессии, который показывает, на сколько единиц в среднем изменится значение

– коэффициентом регрессии, который показывает, на сколько единиц в среднем изменится значение  при изменении

при изменении  на одну единицу.

на одну единицу.

Допустим, что нашей задачей является подбор функции  из параметрического семейства функций

из параметрического семейства функций  наилучшим образом описывающая зависимость

наилучшим образом описывающая зависимость  от

от  В качестве меры отклонения функции

В качестве меры отклонения функции  от исходных наблюдений можно использовать:

от исходных наблюдений можно использовать:

- сумму квадратов отклонений;

- сумму модулей отклонений;

- другие меры отклонений.

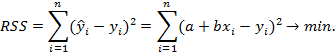

Согласно методу наименьших квадратов (МНК) неизвестные параметры модели выбираются таким образом, чтобы сумма квадратов отклонений эмпирических значений от модельных была минимальной:

Среди преимуществ метода наименьших квадратов следует особенно отметить лёгкость вычислительной процедуры и хорошие по статистическим свойствам оценки. Данные факты объясняют широкое применение данного метода в статистическом анализе. Из недостатков наиболее существенным является – чувствительность к выбросам. Согласно необходимому условию экстремума функции нескольких переменных, необходимо найти частные производные по этим переменным и приравнять их к нулю.

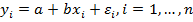

Свойства оценок МНК определяются предположениями относительно свойств случайного возмущения в модели наблюдений. Эти предположения обычно называются условиями Гаусса – Маркова.

Условия Гаусса-Маркова:

1.  – условие, гарантирующее несмещённость оценок МНК.

– условие, гарантирующее несмещённость оценок МНК.

2.  – условие гомоскедастичности, его нарушение приводит к проблеме гетероскедастичности.

– условие гомоскедастичности, его нарушение приводит к проблеме гетероскедастичности.

3.  – условие отсутствия автокорреляции предполагает отсутствие систематической связи между значениями случайного члена в любых двух наблюдениях. Если данное условие не выполняется, то в модели возникает проблема автокорреляции случайных возмущений.

– условие отсутствия автокорреляции предполагает отсутствие систематической связи между значениями случайного члена в любых двух наблюдениях. Если данное условие не выполняется, то в модели возникает проблема автокорреляции случайных возмущений.

4.  для всех

для всех  условие независимости случайного возмущения и объясняющей переменной. Значение любой независимой переменной в каждом наблюдении должно считаться экзогенным, полностью определяемым внешними причинами, не учитываемыми в уравнении регрессии.

условие независимости случайного возмущения и объясняющей переменной. Значение любой независимой переменной в каждом наблюдении должно считаться экзогенным, полностью определяемым внешними причинами, не учитываемыми в уравнении регрессии.

Достаточно часто накладывают ещё одно условие на остатки модели, но данное условие не является условием Гаусса-Маркова:  , оно очень полезно для проверки многих гипотез.

, оно очень полезно для проверки многих гипотез.

Свойства оценок, полученных с помощью МНК:

1. Линейность оценок – оценки параметров  и

и  представляют собой линейные комбинации наблюдаемых значений объясняемой переменной

представляют собой линейные комбинации наблюдаемых значений объясняемой переменной  .

.

2. Несмещённость оценок:

3. Состоятельность оценок:

4. Эффективность – данное свойство означает, что оценка имеет минимальную дисперсию в заданном классе оценок:

Теорема Гаусса-Маркова: если выполнены условия Гаусса-Маркова, тогда оценки  , полученные с помощью метода наименьших квадратов, являются линейными, несмещёнными, эффективными и состоятельными оценками.

, полученные с помощью метода наименьших квадратов, являются линейными, несмещёнными, эффективными и состоятельными оценками.