Систематическая погрешность считается специфической случайной величиной, обладающей некоторыми ее свойствами (СКО, дисперсия). Результаты наблюдений, полученные при наличии систематических погрешностей, называются неисправленными. Систематические погрешности не зависят от числа измерений, при повторных измерениях они остаются постоянными или изменяются по определенному закону. Искажения, вносимые ими в результаты измерений, поддаются исключению или учету. Полученные результаты путем внесения поправки могут быть значительно улучшены, т.е. приближаться к истинному значению.

Способы исключения и учета СИП условно делятся на 4 группы:

1. Устранение источников погрешностей до начала измерений (профилактика погрешностей) т.е. регулировка и ремонт СИ необходимость в которых устанавливается при поверке, а также удаление и защита СИ и объекта измерений от возможного влияния источников погрешности (температура, влажность, магнитные поля, вибрация и т.п.)

2. Исключение погрешностей в процессе измерения (экспериментальное исключение погрешностей) способами замещения, компенсации погрешности по знаку, противопоставления, симметричных наблюдений.

3. Внесение известных поправок в результат измерения (исключение погрешностей вычислением). Поправку можно внести путем вычитания из результата измерения систематической погрешности (поправка по числовому значению равна СИП и противоположна ей по знаку), умножения на поправочный коэффициент (» 1, но может быть как меньше, так и больше).

4. Оценка границ СИП, если их нельзя исключить. Существует большая группа СИ СИП которых изучены, поддаются определению, но они не могут быть использованы для внесения поправок, это интегрирующие СИ или счетчики. Это происходит из-за того, что угловая скорость диска счетчика в каждый момент времени, не строго пропорциональна мощности, т.е. СИП на различных нагрузках различны. Каждому значению мощности соответствует определенная погрешность, однако, использовать эти значения нельзя, так как мощность не может оставаться постоянной в течение всего процесса измерения. С другой стороны нельзя говорить о случайном характере погрешности, потребляемая мощность не является случайной величиной, она зависит от режима работы устройств, потребляющих электроэнергию. Таким образом, нет возможности определить результирующую погрешность. Можно отметить, что если СИП счетчика не превышают ± 2 %, то погрешность учета энергии будет меньше 2 %

Способ последовательных разностей (критерий Аббе). Применяется для обнаружения изменяющихся во времени СИП. Основан на двух вариантах расчета дисперсии:

Если в процессе измерений имела место переменная СИП, то это отразится на значении дисперсии  , так как это значение зависит от среднего. С другой стороны среднее значение практически не влияет на значения двух последовательных (в порядке проведения измерений) результатов измерений, а значит и не окажет влияния на значение последовательных разностей: (Хi+1-Xi) и на значение

, так как это значение зависит от среднего. С другой стороны среднее значение практически не влияет на значения двух последовательных (в порядке проведения измерений) результатов измерений, а значит и не окажет влияния на значение последовательных разностей: (Хi+1-Xi) и на значение  . Отношение дисперсий является критерием для обнаружения СИП.

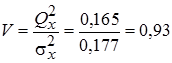

. Отношение дисперсий является критерием для обнаружения СИП.  . Критическая область этого критерия определяется как Р (V < Vq) = q, где q = 1 – P (н-р: Р=0,95 q = 0,05) - уровень значимости, Р - доверительная вероятность. Значение Vq для различных уровней значимости q и числа наблюдений n приводятся в табл.

. Критическая область этого критерия определяется как Р (V < Vq) = q, где q = 1 – P (н-р: Р=0,95 q = 0,05) - уровень значимости, Р - доверительная вероятность. Значение Vq для различных уровней значимости q и числа наблюдений n приводятся в табл.

Пример:

| n | Xi | Di = Xi+1-Xi |

| Vi = Xi - Хср |

|

| 15,2 | - | - | - 0,15 | 0,0225 | |

| 15,9 | 0,7 | 0,49 | 0,55 | 0,3025 | |

| 15,4 | - 0,5 | 0,25 | 0,05 | 0,0025 | |

| 14,9 | - 0,5 | 0,25 | - 0,45 | 0,2025 | |

| å | 61,4 | - 0,3 | 0,99 | 0,0 | 0,53 |

Хср = 61,4 / 15,35;  ;

;  ;

;

Далее обращаемся к табл. (при n = 4 для q = 0,001 критерий Аббе Vq = 0,295; для q = 0,01 Vq = 0,313; для q = 0,05 Vq = 0,390). Как видно из табл. для всех уровней значимости V > Vq, т.е. условия измерений для приведенного ряда оставались неизменными и СИП в результатах наблюдений нет.

Дисперсионный анализ (критерий Фишера). Метод используется при проведении многократных измерений, состоящих из достаточного числа серий каждая из которых соответствует определенным значениям факторов, оказывающих влияние на результаты. Метод основан на нахождении отношений между межсерийной и внутрисерийной дисперсии.

Проводится ряд опытов (N - число измерений), далее они разбиваются на серии (S > 3) по nj результатов наблюдений в каждой серии. Для каждой серии находят среднее значение  , а затем внутрисерийную дисперсию.

, а затем внутрисерийную дисперсию.

- результат i-го измерения в j-ой серии.

- результат i-го измерения в j-ой серии.

Внутрисерийная дисперсия характеризует случайные погрешности измерений. В тоже время разница в результатах наблюдений обусловлена не только случайными погрешностями, но и систематическими между результатами наблюдений, сгруппированным по сериям.

выражает силу действия фактора, вызывающего систематические различия между сериями.

выражает силу действия фактора, вызывающего систематические различия между сериями.

Критерием оценки наличия СИП является критерий Фишера:  . Критическая область этого критерия определяется как Р (F > Fq) = q. Значения Fq для различных уровней значимости определяются по таблице, зависит от числа измерений N и числа серий: k1 = S-1; k2 = N – S.

. Критическая область этого критерия определяется как Р (F > Fq) = q. Значения Fq для различных уровней значимости определяются по таблице, зависит от числа измерений N и числа серий: k1 = S-1; k2 = N – S.

Например:

Случайные погрешности (СП)

Случайная погрешность возникает при одновременном воздействии нескольких источников, каждый из которых в отдельности оказывает незначительное влияние на результат, однако, суммарное воздействие может оказаться достаточно большим. Каждый источник СП в данный момент времени ведет себя по-разному, без закономерностей и связей друг с другом, это и приводит к тому, что суммарное их действие проявляется в результатах измерений без закономерной связи с предыдущим и последующим.

При рассмотрении влияния случайных погрешностей на результат измерений основная задача заключается в изучении свойств совокупностей результатов отдельных наблюдений. Теория вероятности дает математические методы изучения свойств случайных событий в больших совокупностях.

Универсальным способом описания случайных величин является отыскание их интегральных или дифференциальных функций распределения. Интегральной функцией распределения называют функцию F (x), определяющую вероятность того, что случайная величина xi в результате испытания (i -ом опыте) примет значение, меньшее x, т.е. F(x) = P(xi < x) = P(- ¥ < xi £ x). Свойства функции: 1. Значения функции распределения принадлежат отрезку [0,1]. Это свойство следует из определения функции распределения как вероятности: вероятность всегда неотрицательное число, не превышающая 1.

Универсальным способом описания случайных величин является отыскание их интегральных или дифференциальных функций распределения. Интегральной функцией распределения называют функцию F (x), определяющую вероятность того, что случайная величина xi в результате испытания (i -ом опыте) примет значение, меньшее x, т.е. F(x) = P(xi < x) = P(- ¥ < xi £ x). Свойства функции: 1. Значения функции распределения принадлежат отрезку [0,1]. Это свойство следует из определения функции распределения как вероятности: вероятность всегда неотрицательное число, не превышающая 1.

2. Функция неубывающая, т.е. F(x2) >= F(x1), если х2 > х1. Следствие: Вероятность того, что случайная величина х примет значение, заключенное в интервале (х1, х2) равна приращению функции распределения на этом интервале: Р(х1<= х < x2) = F(x2) - F(x1)

Более наглядным является описание свойств результатов измерений и СП с помощью дифференциальной функции распределения или плотности распределения вероятностей, которая является первой производной от функции распределения. р(х) = dF/dx. Свойства плотности распределения: 1. Плотность распределения неотрицательная функция (р(х) > 0) это следует из того, что функция распределения неубывающая, ее производная неотрицательна. График плотности распределения называют кривой распределения.

2. Несобственный интеграл от плотности распределения в пределах от - ¥ до + ¥ равен 1.

Док-во: несобственный интеграл выражает вероятность события, состоящего в том, что случайная величина примет значение, принадлежащее интервалу (- ¥, + ¥). Очевидно, что такое событие достоверно. Геометрически это означает, что все площадь криволинейной трапеции, ограниченной осью ОХ и кривой распределения =1. В частности, если все возможные значения случайной величины принадлежат интервалу (х1, х2), то =1.

По форме кривой плотности вероятности р(х) можно судить о том, какие значения случайной величины х наиболее вероятны, а какие менее.

Случайные величины (СВ) характеризуются следующими параметрами:

1. Центр распределения, его координата показывает положение СВ на числовой оси. Одним из способов его определения является нахождение медианы или 50% квантиля Хм на оси х, вероятность появления различных значений от которой слева и справа одинакова и равно 0,5 т.е.:

р(х)

р(х)

| |||

| |||

х

х

При симметричной кривой р(х) в качестве центра может использоваться абсцисса моды, или максимума распределения Х м. Распределения с одним max. Называются одномодальными, с двумя - двухмодальными. Распределения у которых в средней части расположен не max a min, называют антимодальными. Существуют распределения у которых max отсутствует - равномерное.

При симметричной кривой р(х) в качестве центра может использоваться абсцисса моды, или максимума распределения Х м. Распределения с одним max. Называются одномодальными, с двумя - двухмодальными. Распределения у которых в средней части расположен не max a min, называют антимодальными. Существуют распределения у которых max отсутствует - равномерное.

Для ограниченных распределений (равномерного, трапецеидального) применяют оценку в виде центра размаха, где Х 1 и Х 2 первый и последний член вариационного ряда.

Для двухмодального распределения - в виде центра сгиба, где Х с1, Х с2 абсциссы точек, в которых распределение достигает max.

.

.

Можно определить центр распределения, как математическое ожидание, которое приближенно равно среднему значению случайной величины.

Математическим ожиданием непрерывной случайной величины Х все возможные значения которой принадлежат отрезку [a, b], называют определенный интеграл. Если возможные значения принадлежат всей оси ОХ.

.

.

2. Начальный и центральный моменты распределения.

Начальным моментом s -го порядка случайной величины Х называется математическое ожидание s -й степени этой величины.

т.е. первым начальным моментом является математическое ожидание, а нулевой начальный момент =1. Переход к моментам более высоких порядков позволяет учесть влияние на (M[x]) математическое ожидание того возможного значения, которое велико и имеет малую вероятность.

т.е. первым начальным моментом является математическое ожидание, а нулевой начальный момент =1. Переход к моментам более высоких порядков позволяет учесть влияние на (M[x]) математическое ожидание того возможного значения, которое велико и имеет малую вероятность.

Центрированной СВ называют отклонение СВ от ее математического ожидания  . Моменты центрированной СВ называются центральными моментами, они аналогичны моментам относительно центра масс в механике. Центральным моментом порядка s СВ Х называется математическое ожидание s -й степени центрированной СВ.

. Моменты центрированной СВ называются центральными моментами, они аналогичны моментам относительно центра масс в механике. Центральным моментом порядка s СВ Х называется математическое ожидание s -й степени центрированной СВ.

3. Энтропийное значение погрешности.

Измерение это процесс получения измерительной информации. Основная идея теории информации состоит в том, что с информацией можно почти обращаться также как с другими физическими величинами. С токи зрения теории информации случайная помеха (погрешность) будет являться дезинформацией. Вносимая помехой дезинформация будет определяться ее мощностью (СКО), видом закона распределения самой помехи. Дезинформирующее действие помехи, независимо от закона распределения, если помеха в вероятностном смысле не зависит от сигнала, определяется ее энтропией Н (х) т.е. мерой неопределенности измеряемой величины до ее измерения.

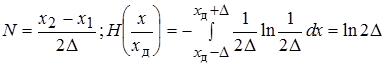

Количество информации J определяется как разность энтропий, где первое слагаемое энтропия измеряемой величины до ее измерения, а второе энропия действительного значения измеряемой величины х или мера интервала неопределенности вокруг полученного измерения показания х д, т. е. энтропия погрешности измерения.

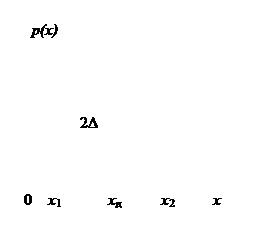

Измеряется величина х СИ прибором со шкалой от х 1 до х 2. Вероятность получить показания прибора в интервале от -¥ до х 1 и от +¥ до х 2 равна нулю, т.е. р(х)= 0. Результат измерения с равной вероятностью может оказаться в интервале от х 1 до х 2. Тогда вероятностное описание

Измеряется величина х СИ прибором со шкалой от х 1 до х 2. Вероятность получить показания прибора в интервале от -¥ до х 1 и от +¥ до х 2 равна нулю, т.е. р(х)= 0. Результат измерения с равной вероятностью может оказаться в интервале от х 1 до х 2. Тогда вероятностное описание

ситуации до измерения будет равномерным распределением х в интервале от х 1 до х 2. Т.е.

Энтропия - логарифмическая мера длины интервала неопределенности до измерения. Доверительное значение измеряемой величины лежит в пределах интервала неопределенности шириной d = 2D, где ± D - погрешность прибора (с равномерным распределением) или энтропийное значение погрешности d = 2Dэ = еН(х/хд) , d – энтропийный интервал неопределенности результата измерения. Смыслом измерения будет в сужение интервала неопределенности от (х 2 - х 1) до измерения до интервала d = 2D после измерения. Интервал неопределенности сократиться в N раз, это число показывает, сколько интервалов неопределенности укладывается во всем диапазоне, т.е. N - число градаций измеряемой величины. Энтропия результата измерения после получения показания х д:

Количество информации, полученное в результате измерения:

Н(х) - неопределенность до измерения; Н(х/ хд ) - неопределенность после измерения.

Для нормального распределения последнее отношение равно:

Вторая формула для распределения Симпсона.

Соотношение между Dэ и СКО различны для всех законов распределения, поэтому часто используется энтропийный коэффициент К = Dэ/s.